Мы все еще находимся в стадии активного развития новейших приложений для искусственного интеллекта, в частности, больших языковых моделей и так называемых “трансформеров”, таких как чат GPT. Трансформаторы – это модель глубокого обучения, которая использует внимание к себе для дифференцированного взвешивания важности вводимых данных, включая любое рекурсивное использование собственных выходных данных. Этот процесс основан на использовании огромных объемов обучающих данных, в основном размером с Интернет. Это дало потрясающие результаты, но с течением времени мы начинаем видеть реальные пределы такого подхода.

Мы все еще находимся в стадии активного развития новейших приложений для искусственного интеллекта, в частности, больших языковых моделей и так называемых “трансформеров”, таких как чат GPT. Трансформаторы – это модель глубокого обучения, которая использует внимание к себе для дифференцированного взвешивания важности вводимых данных, включая любое рекурсивное использование собственных выходных данных. Этот процесс основан на использовании огромных объемов обучающих данных, в основном размером с Интернет. Это дало потрясающие результаты, но с течением времени мы начинаем видеть реальные пределы такого подхода.

Я действительно вижу тенденцию к ложной дихотомии, когда речь заходит об ИИ: с одной стороны, ИИ – это шумиха, а с другой – ИИ собирается спасти / уничтожить мир. Отчасти это соответствует типичной тенденции переоценивать краткосрочный технологический процесс в угоду шумихе и недооценивать долгосрочный прогресс в угоду цинизму. Я думаю, реальность находится где–то посередине – новейшие приложения ИИ чрезвычайно эффективны, но имеют свои пределы и не будут совершенствоваться бесконечно.

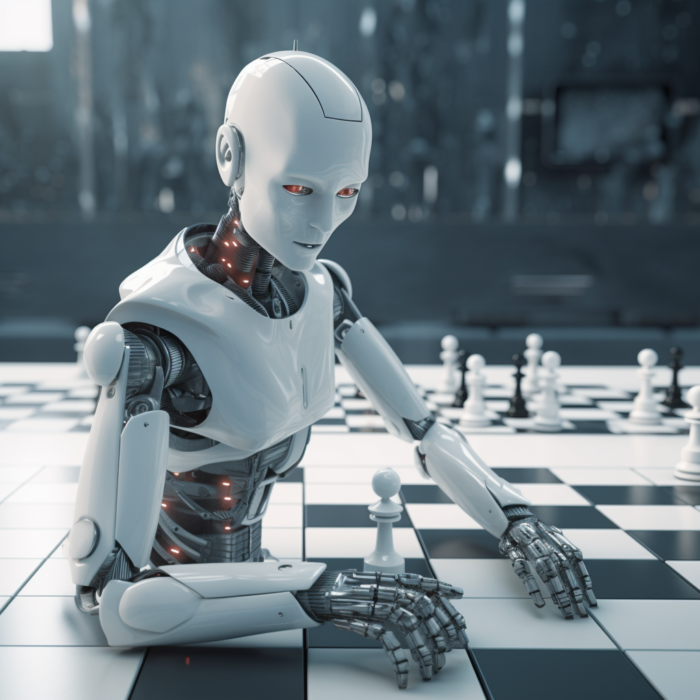

Я активно использую несколько программ с искусственным интеллектом, таких как Chat GPT и Midjourney, и со временем их ограничения становятся все более очевидными. Самое большое ограничение этих приложений с искусственным интеллектом заключается в том, что они не могут мыслить так, как это делают люди. Они имитируют результаты мышления без какого-либо реального понимания. Они делают это, обучаясь на огромной базе данных и используя, по сути, статистику, чтобы предсказать, что будет дальше (какой фрагмент слова или элемент изображения). Это дает потрясающие результаты, и до сих пор шокирует, что это работает так хорошо, но также приводит к интересным сбоям. Например, в Midjourney (и приложении для создания изображений с искусственным интеллектом) при создании подсказок, которые приводят к выбору изображений, вы не можете объяснить приложению так, как объяснили бы человеку, чего вы хотите. Вы пытаетесь найти правильные триггеры, но эти триггеры очень причудливы и сильно зависят от данных обучения. Использование разных слов для описания одной и той же вещи может привести к совершенно разным результатам в зависимости от того, как эти слова использовались в данных обучения.

То же самое верно и для GPT-чата. Чем необычнее ваш запрос, тем более причудливым будет результат. И результаты основаны не только на реальности, но и на статистическом использовании слов. Вот почему существует проблема с так называемыми галлюцинациями. Вы получаете статистически вероятный ответ, а не реальный, и неточности в данных приведут к неточностям в результате. Задача на самом деле не понимает, о чем она говорит. Она буквально притворяется, имитируя человеческий язык путем статистической реконструкции того, что она выучила.

Мы видим это ограничение и в других областях применения ИИ. Предполагалось, что к 2020 году у нас будут беспилотные автомобили, но, возможно, до этого еще десять лет. Это связано с тем, что приложения для управления ИИ постепенно запутываются в новых или необычных ситуациях. Они особенно плохо предсказывают действия людей, в чем водители-люди разбираются гораздо лучше. Таким образом, они великолепны в контролируемых или предсказуемых ситуациях, но могут действовать хаотично, когда бросают мяч по кривой, что не очень хорошо для любого водителя.

Но вот главный вопрос : можно ли устранить эти текущие ограничения ИИ за счет постепенного совершенствования существующих технологий или же для их устранения потребуются фундаментальные ограничения, которые потребуют новых инноваций? Все больше кажется, что последнее ближе к истине.

И вот тут-то мы начинаем переоценивать краткосрочный прогресс. Люди смотрят на прогресс в области искусственного интеллекта за последнее десятилетие, даже за последние несколько лет, и ошибочно предполагают, что этот уровень или прогресс сохранится, а затем линейно экстраполируют его на будущее. Но эксперты говорят, что это не обязательно так. Для этого есть две основные причины. Первая – отсутствие истинного понимания, которое я только что описал. Вторая – мы приближаемся к практическим пределам использования глубокого обучения на больших массивах данных. Например, обучающий чат GPT обошелся в 100 миллионов долларов и потребовал создания огромной инфраструктуры с аппаратным обеспечением и энергопотреблением. Есть некоторые практические ограничения на то, насколько больше мы можем получить. Кроме того, похоже, что отдача от расширения уменьшается. Таким образом, прогресс в реализации этого подхода может быть близок к постепенному. Постепенные улучшения, скорее всего, приведут к повышению эффективности и скорости, но, возможно, не приведут к значительно лучшим результатам.

Преодоление “сверхъестественной долины” почти человеческого может оказаться невозможным без совершенно нового подхода. Или же для этого может потребоваться на порядки больший технологический прогресс, чем для достижения того уровня, на котором мы находимся сейчас. Существует множество примеров из истории технологий, которые могут пролить свет на этот вопрос. В 1980-х годах высокотемпературные сверхпроводники пережили фазу ажиотажа. Это позволило создать действительно полезную технологию, но все предполагали, что мы быстро доберемся до сверхпроводников комнатной температуры. Прошло почти 40 лет, а мы, возможно, ни на шаг не продвинулись, потому что в конечном итоге этот путь оказался тупиковым. Аналогичным образом, нынешний путь развития технологий искусственного интеллекта может не привести к созданию общего ИИ с истинным пониманием. Может потребоваться совершенно иной подход.

Я думаю, что сейчас произойдет то, что мы вступим в период, когда рынок узнает, как наилучшим образом использовать эту технологию искусственного интеллекта, и узнает, в чем она хороша, а в чем нет. Будут происходить постепенные улучшения. Появятся новые способы использования технологии transformer. Но ИИ в рамках этой технологической парадигмы не будет совершенствоваться вечно и достигнет своих пределов, в основном из-за недостаточного понимания его сути. Может сложиться впечатление, что пузырь ажиотажа вокруг ИИ лопнул. Но тогда возникнет недооценка долгосрочного прогресса. Исследователи придумают новые инновации, которые выведут ИИ на новый уровень, и процесс, скорее всего, повторится.

Трудно предсказать, сколько времени займет этот цикл. В исследования ИИ вкладываются миллиарды долларов, и над этим работает целая индустрия очень умных людей. Никто не знает, к чему они придут. Но отсутствие истинного понимания может оказаться действительно крепким орешком и может ограничить возможности ИИ на десятилетия. Посмотрим.