Я принадлежу к поколению, которое, по сути, пережило появление и эволюцию персональных компьютеров. У меня многолетний опыт активного пользователя и энтузиаста, поэтому я смог заметить некоторые закономерности. Одной из закономерностей является взаимосвязь между мощностью компьютерного оборудования и требованиями, предъявляемыми к программному обеспечению. В течение первых двух десятилетий существования персональных компьютеров производительность и быстродействие аппаратного обеспечения, безусловно, были ограничивающим фактором с точки зрения удобства конечного пользователя. Программное обеспечение, по сути, было встроено в имеющееся оборудование, и по мере того, как оборудование постоянно совершенствовалось, возможности программного обеспечения увеличивались, чтобы заполнить доступное пространство. То же самое касалось емкости жесткого диска – сначала каждый новый диск казался бездонной ямой, но размер файлов быстро увеличивался, чтобы использовать преимущества новой емкости.

Я принадлежу к поколению, которое, по сути, пережило появление и эволюцию персональных компьютеров. У меня многолетний опыт активного пользователя и энтузиаста, поэтому я смог заметить некоторые закономерности. Одной из закономерностей является взаимосвязь между мощностью компьютерного оборудования и требованиями, предъявляемыми к программному обеспечению. В течение первых двух десятилетий существования персональных компьютеров производительность и быстродействие аппаратного обеспечения, безусловно, были ограничивающим фактором с точки зрения удобства конечного пользователя. Программное обеспечение, по сути, было встроено в имеющееся оборудование, и по мере того, как оборудование постоянно совершенствовалось, возможности программного обеспечения увеличивались, чтобы заполнить доступное пространство. То же самое касалось емкости жесткого диска – сначала каждый новый диск казался бездонной ямой, но размер файлов быстро увеличивался, чтобы использовать преимущества новой емкости.

В те дни мы с друзьями были в курсе всех характеристик нашего текущего оборудования – оперативной памяти, емкости жесткого диска, скорости процессора, а затем и количества ядер – и мы участвовали в дружеской гонке вооружений, постоянно опережая друг друга. Однако где-то после 2000 года ситуация изменилась. Что касается персональных компьютеров, то мощности аппаратного обеспечения, казалось, наконец-то стало более чем достаточно для всего, что мы могли бы захотеть сделать. Мы перестали зацикливаться на таких вещах, как скорость процессора, за исключением, конечно, нашего игрового компьютера. Видеоигры были единственным повседневным приложением, которое по-настоящему подчеркивало мощь нашего оборудования. Внезапно характеристики вашей видеокарты стали самыми важными характеристиками.

И это тоже начинает снижаться. Я знаю, что есть геймеры, которые до сих пор создают устаревшие устройства, расширяя возможности обычных компьютеров, но что касается меня, то, пока мой компьютер в основном обновлен, мне не нужно беспокоиться о запуске новейшей игры. Однако я по-прежнему обращаю внимание на статистику своих игровых карт, особенно когда появилась виртуальная реальность. Всегда появляется какое-нибудь новое приложение, которое заставляет вас захотеть обновить оборудование.

Сегодня этой новинкой является искусственный интеллект (ИИ), хотя он предназначен не столько для потребителей, сколько для крупных центров обработки данных. Новейшие технологии искусственного интеллекта, такие как Chat GPT, использующие предварительно обученную технологию transformer, требуют аппаратного обеспечения. Интересно, что они в основном полагаются на видеокарты, которые являются самыми быстрыми процессорами массового производства. То же самое относится и к крипто-майнингу, который привел к нехватке видеокарт и резкому росту цен (проклятые крипто-майнеры). Видеоигры действительно являются важным драйвером развития вычислительного оборудования.

По оценкам экспертов, в то время как скорость обработки данных удваивается примерно каждые 18 месяцев (знаменитый закон Мура), требования к ИИ удваиваются примерно каждые 3,5 месяца. Это приведет к увеличению разрыва между мощностью оборудования и требованиями к программному обеспечению ИИ. Для обучения в GPT 3 использовалась в 100 раз большая вычислительная мощность, чем в GPT, а в GPT 4 – в 10 раз большая мощность, чем в GPT3. Обучение в GPT 4 обошлось в 100 миллионов долларов. Приложения с искусственным интеллектом в настоящее время потребляют столько же энергии, сколько страны – в одном исследовании было подсчитано, что на обучение и запуск искусственного интеллекта Google уходит столько же энергии, сколько в Ирландии. По оценкам, к 2027 году приложения ИИ будут потреблять 85-134 тераватт-часа в год, столько же, сколько в таких странах, как Швеция.

Вопрос в том, замедлят ли эти ограничения в использовании оборудования и энергии разработку и использование ИИ? Если мои наблюдения за последние полвека подтвердятся, то я бы сказал, что нет. Точно так же, как программное обеспечение расширяется, чтобы заполнить пространство, созданное аппаратным обеспечением, аппаратное обеспечение разрабатывается специально для удовлетворения потребностей популярных программных приложений, которые затем подключаются к другому программному обеспечению, и так далее. Базовые вычисления привели к тому, что в видеоиграх появились все более мощные видеокарты, которые облегчили майнинг криптовалют. (Я знаю, это чрезмерное упрощение, но, по-моему, в основном так и есть) Какое оборудование находится на стадии разработки, которое может стать основой для искусственного интеллекта в ближайшем будущем? Вот несколько вариантов.

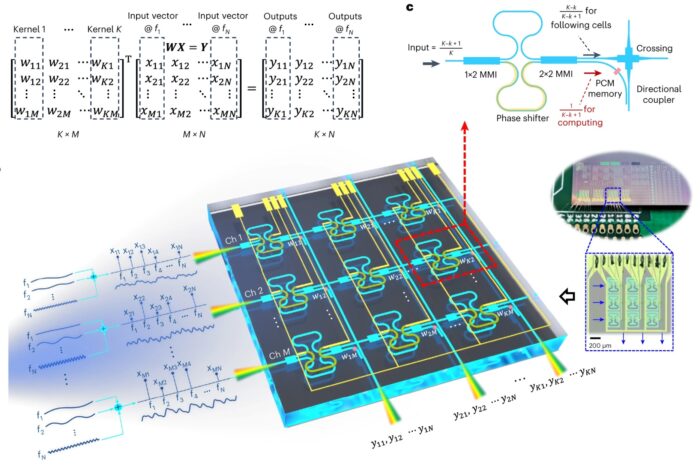

Вот исследование, недавно опубликованное в nature photonics – Многомерная обработка с использованием фотонного тензорного ядра с данными непрерывного действия. По сути, эта технология использует свет вместо электронов для передачи данных. Одно из преимуществ использования света (фотоники) заключается в том, что вы можете кодировать параллельные потоки данных в различных длинах волн (цветах) света. Используйте 10 различных длин волн, и вы сможете передавать данные в 10 раз быстрее. Конечно, теоретически вы могли бы использовать гораздо больше. В этом исследовании они использовали радиочастоты. Они также использовали трехмерную конструкцию чипа, что еще больше повысило эффективность параллельной обработки. По их оценкам, с помощью 6 параллельных входов и выходов они могут повысить энергоэффективность и плотность обработки в 100 раз. Это означало бы, что один центр обработки данных будет выполнять работу 100 центров обработки данных. Но использование фотоники таким образом может иметь гораздо больший потенциал. Это может вывести ООН на технологический путь, позволяющий на много порядков увеличить скорость обработки и эффективность.

Еще одним потенциальным стимулом для развития ИИ являются квантовые вычисления. Ранее в этом году я написал обзор квантовых вычислений. В основном квантовые компьютеры используют qbits вместо битов – это биты, которые запутаны и, следовательно, могут кодировать 2 ^ n бит информации, а не просто n бит (где n – количество кубитов). В результате квантовый компьютер может решать некоторые задачи за считанные минуты, на решение которых даже банкам традиционных суперкомпьютеров потребовалось бы больше времени, чем возраст Вселенной. Программное обеспечение с искусственным интеллектом, разработанное для работы на квантовых компьютерах, может стать невероятно более мощным, чем все, что мы имеем сегодня. Трудно даже представить себе его потенциал.

Однако квантовые компьютеры все еще находятся в стадии разработки, и им предстоит преодолеть несколько критических препятствий. Одним из них является исправление ошибок. Запутанные qbit-биты имеют тенденцию распутываться, например, теряя свои данные. Но прогресс в области квантовых компьютеров неуклонно растет, и нет оснований полагать, что этот прогресс замедлится или остановится. Например, одна команда в Гарварде недавно опубликовала методику самокорректирующихся квантовых вычислений. Это может стать значительным достижением. Обнадеживающие результаты появляются каждую неделю. Пока еще слишком рано говорить о сроках и будущем потенциале квантовых компьютеров, но темпы их развития чрезвычайно обнадеживают, и ни одна из проблем не кажется неразрешимой.

Я думаю, что суть в том, что мы стали свидетелями невероятного прогресса в разработке программного обеспечения для искусственного интеллекта, что привело к появлению множества новых приложений, которые продолжают активно развиваться. В ближайшем будущем могут появиться и другие разработки в области программного обеспечения. Теперь настала очередь аппаратных средств создавать прорывные решения, соответствующие требованиям искусственного интеллекта. Возможно, мы стоим на пороге революции в фотонике. Одно из предостережений заключается в том, что я уже много лет слышу о фотонике, поэтому до сих пор трудно сказать (с моей точки зрения стороннего наблюдателя), насколько далеко продвинулась эта технология. Возможно, вслед за фотоникой мы также увидим, как квантовые компьютеры вступят в свои права. Или, возможно, существует какая-то другая аппаратная технология (на основе графена?), готовая занять лидирующие позиции.

К 2030-м годам индустрия искусственного интеллекта, вероятно, будет стоить триллионы долларов. Такой потенциал влечет за собой огромные инвестиции в технологические исследования и разработки, что является довольно хорошим показателем будущих технологий.