Большинство читателей, вероятно, знакомы с тестом Тьюринга – концепцией, предложенной одним из первых специалистов по вычислительной технике Аланом Тьюрингом в 1950 году и первоначально называвшейся “Имитационная игра”. Читать оригинальную статью очень интересно. Тьюринг не пытался ответить на вопрос “могут ли машины мыслить”. Он отклонил этот вопрос как слишком расплывчатый и вместо него задал рабочий вопрос, который стал известен как тест Тьюринга. В нем участвуют эксперт и два испытуемых, которые не могут видеть друг друга, а общаются только с помощью текста. Специалист по оценке знает, что один из двух испытуемых – машина, а другой – человек, и он может задавать любые вопросы, которые ему нравятся, чтобы определить, кто из них кто. Считается, что машина прошла тест, если она в процентном соотношении превышает определенный порог для экспертов по оценке.

Большинство читателей, вероятно, знакомы с тестом Тьюринга – концепцией, предложенной одним из первых специалистов по вычислительной технике Аланом Тьюрингом в 1950 году и первоначально называвшейся “Имитационная игра”. Читать оригинальную статью очень интересно. Тьюринг не пытался ответить на вопрос “могут ли машины мыслить”. Он отклонил этот вопрос как слишком расплывчатый и вместо него задал рабочий вопрос, который стал известен как тест Тьюринга. В нем участвуют эксперт и два испытуемых, которые не могут видеть друг друга, а общаются только с помощью текста. Специалист по оценке знает, что один из двух испытуемых – машина, а другой – человек, и он может задавать любые вопросы, которые ему нравятся, чтобы определить, кто из них кто. Считается, что машина прошла тест, если она в процентном соотношении превышает определенный порог для экспертов по оценке.

Но Тьюринг, по-видимому, верил, что тест Тьюринга будет разумной проверкой того, может ли компьютер мыслить как человек. Он систематически рассматривает ряд потенциальных возражений против этого вывода. Например, он цитирует речь профессора Джефферсона, произнесенную в 1949 году:

“Только когда машина сможет написать сонет или концерт на основе мыслей и эмоций, а не на основе случайного сочетания символов, мы сможем согласиться с тем, что машина равна мозгу, то есть не только написать это, но и знать, что она это написала”.

Затем Тернинг отвергает этот аргумент как солипсистский – о том, что мы можем знать, что мы сами обладаем сознанием, только потому, что мы обладаем сознанием. В качестве отступления, я с этим не согласен. Люди могут знать, что другие люди обладают сознанием, потому что у всех нас одинаковый мозг. Но искусственный интеллект (ИИ) был бы принципиально иным, и вопрос в том, как ИИ создает свои результаты? Тьюринг приводит в качестве примера того, насколько его тест был бы достаточным, автора сонета, защищающего творческий выбор своего собственного сонета:

Что бы сказал профессор Джефферсон, если бы машина, пишущая сонеты, смогла ответить подобным образом во всеуслышание? Я не знаю, счел бы он, что машина “просто искусственно сигнализирует” об этих ответах, но если бы ответы были такими же удовлетворительными и устойчивыми, как в приведенном выше отрывке, я не думаю, что он назвал бы это “простым изобретением”. Я думаю, что эта фраза предназначена для обозначения таких устройств, как включение в аппарат записи того, как кто-то читает сонет, с соответствующим переключением, позволяющим время от времени включать его. Короче говоря, я думаю, что большинство из тех, кто поддерживает аргумент, основанный на сознании, можно убедить отказаться от него, а не принуждать к позиции солипсизма. Тогда они, вероятно, захотят пройти наш тест.

По сути, Тьюринг утверждает, что машины, которая в достаточной степени прошла его тест, продемонстрировав реальное понимание некоторого материала, было бы достаточно, чтобы установить, что она “мыслит” как человек – то, что мы сейчас назвали бы искусственным общим интеллектом (AGI). Однако, по прошествии семидесяти трех лет, я думаю, что Тьюринг оказался неправ. Узкие ИИ, те, которые работают скорее благодаря “изобретению” “искусственной сигнализации”, чем по принципу “машина равна мозгу”, смогли добиться результатов, соответствующих примеру Тьюринга. Большие языковые модели, построенные на технологии transformer (ChatGPT), могут написать сонет и защитить свой выбор. (Я только что сделал это. Сделай это сам – возможно, это превосходит пример Тьюринга о том, чего не смогла бы сделать машина, не обладающая мышлением.)

Люди умны, и ученые-компьютерщики выяснили, как использовать возможности узкого ИИ для достижения целей, которые в прошлом, как наивно полагал Тьюринг, требовали общего ИИ (возможно, для начала они обыгрывали людей в шахматы). Нам нужен новый тест для искусственного интеллекта. Вот почему ученые-компьютерщики предложили то, что они назвали тестом Тонга, не в честь человека, а в честь китайского слова, означающего “общий”.

В статье не описывается эксплуатационный тест, а предлагаются функции УЧИ, которые необходимо продемонстрировать, чтобы считать его по-настоящему разумным объектом. Статья немного затянута, но вот основные моменты. Во-первых, они предполагают, что УЧИ должен быть “основан на динамических физических и социальных взаимодействиях (DEPSI)”. Далее они предлагают пять важнейших характеристик УЧИ DEPSI.

Во-первых, он должен демонстрировать бесконечную систему генерации задач. Настоящий AGI должен быть адаптируемым к потенциально бесконечному пространству задач, а не ограничиваться конечным (пусть и огромным) количеством задач, которые он может выполнить. Идея здесь в том, что AGI должен на определенном уровне понимать текущую задачу. Они могут перейти от общей команды “очистить это пространство” к созданию конкретных задач, адаптированных к любым условиям, которые они находят в пространстве, включая создание подзадач. Ит-отдел должен понимать, что означает “очистить”, и понимать, как достичь этой цели, без инструктажа или обучения тому, какие шаги следует предпринять.

Roomba, напротив, не знает, что делает уборку. Он просто следует алгоритму. Именно это делает системы AGI “хрупкими” – они выходят из строя, когда сталкиваются с новыми препятствиями, потому что у них нет более глубокого понимания того, что они делают. В качестве примера авторы приводят следующий: что бы сделал ИИ, если бы ему попалась купюра в 100 долларов? Выбросил бы он ее как мусор или признал бы, что она имеет ценность, и отложил в сторону?

Во-вторых, УЧИ должен иметь систему ценностей, которую авторы сводят к ”…двойной системе U–V”. U-система описывает понимание агентом внешних физических или социальных правил, в то время как V-система включает в себя внутренние ценности агента, которые определяются как набор ценностных функций, на основе которых строится самостоятельное поведение агента.” Это относится к генерации бесконечных задач – у AGI есть базовые ценности или правила, на основе которых он может генерировать бесконечные конкретные задачи. Например, он может знать, что человеческая жизнь имеет ценность, и самостоятельно генерировать задачи для защиты человеческой жизни.

Поэтому авторы определяют третий критерий как “самогенерируемые задачи”. Таким образом, эти первые три характеристики можно обобщить, поскольку истинная система AGI должна иметь систему ценностей, как внутренних, так и внешних, с помощью которой она может самостоятельно генерировать потенциально бесконечное количество конкретных задач.

Однако, кроме того, он должен понимать кое-что о том, как устроена Вселенная, и это начинается с понимания причинно-следственных связей. Он должен обладать базовым пониманием причин и следствий и уметь использовать это понимание для решения проблем. Например, если ему нужно достать что-то с высокой полки, до которой он не может дотянуться, он должен понимать, что если он оттолкнется от нее длинной палкой, то под действием силы тяжести предмет упадет ему в руки.

Это относится к последнему варианту реализации функции. Учетная запись DEPSI должна быть воплощена каким-либо образом, который может быть физическим или виртуальным. Она должна существовать в мире как отдельная сущность, способная взаимодействовать с другими объектами в мире посредством причинно-следственной цепочки.

Авторы предполагают, что УЧИ, который может продемонстрировать эти пять характеристик, должен быть настоящим УЧИ – человекоподобным разумным существом. Или, по крайней мере, они разрабатывают специальную среду, в которой эти способности и черты могут быть протестированы. Мне нравится направление, в котором они работают. Они предлагают взаимосвязанные возможности, которые демонстрируют более глубокое понимание ценностей и причинно-следственных связей. Безусловно, система, функционирующая таким образом, намного ближе к AGI, чем, например, модель большого языка, основанная на грубой силе. У ChatGPT нет понимания или ценностей, но он имитирует систему, которая это делает, потому что это языковая модель, и мы используем язык как маркер мышления. Таким образом, он хорош для создания иллюзии мышления, но это всего лишь язык моделирования.

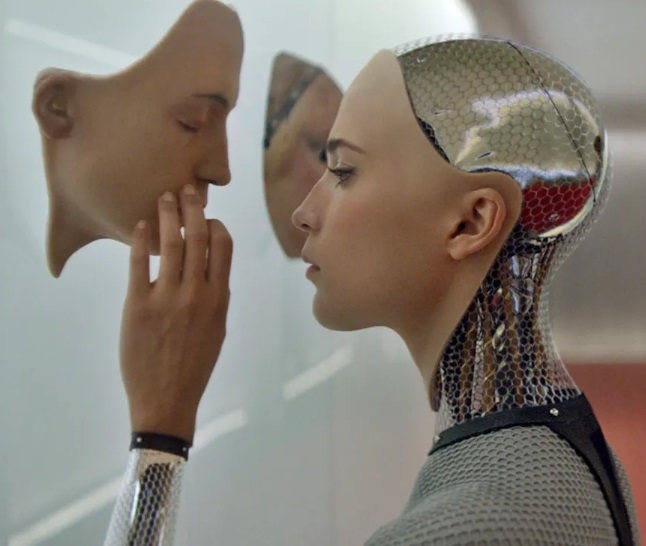

Однако я должен сказать, что мне больше нравится тест, предложенный в фильме “Из машины”. В фильме Натан Бейтман, технический миллиардер, разработавший робота по имени АВА, приглашает программиста Калеба Смита пообщаться с АВОЙ, чтобы определить, действительно ли, по его мнению, она находится в сознании. На самом деле Бейтман проводит более глубокий эксперимент, чтобы выяснить, сможет ли АВА манипулировать Калебом, чтобы обеспечить себе свободу. Аве нужно было бы иметь представление о психике (о том, что у других людей есть мысли и чувства) и понимать правила социального взаимодействия людей, а также причинно-следственные связи в решении проблем. Затем ей нужно было бы разработать план, как манипулировать Калебом, чтобы добиться ее освобождения. Ava должна была бы сгенерировать все пять вышеперечисленных функций, а затем и некоторые из них.

На самом деле, я бы специально добавил к тесту Тонга демонстрацию теории разума и сказал бы, что это самая убедительная особенность из всех, что ИИ действительно обладает сознанием. Есть ли лучший способ продемонстрировать, что система обладает сознанием, чем продемонстрировать понимание того, что другие мыслящие существа также обладают сознанием и чувствами. Это понимание приходит в результате проецирования собственного сознания на других.

У нас все еще есть проблема с действительно хорошей имитацией искусственного интеллекта – если бы он был запрограммирован на имитацию человеческого языка и поведения, мы могли бы ошибочно сделать вывод о теории разума на основе результатов. Вот почему функция Tong по–прежнему важна – необходимы такие вещи, как бесконечные самогенерируемые задачи, основанные на более глубоком понимании значений и причинно-следственных связей. Но, в конечном счете, нам также нужно кое-что знать о том, как работает система. Мы знаем, что ChatGPT – это просто очень хороший чат-бот, предварительно обученный большому количеству человеческих языков. Но если бы поведение, основанное на теории разума, возникло из AGI, не будучи запрограммированным и обученным имитировать такое поведение, это было бы убедительно.

Это действительно интересный мысленный эксперимент – как мы можем узнать, что УЧИ действительно обладает сознанием? Некоторая комбинация или повторение теста Тонга с тестом Ex Machina, безусловно, были бы убедительными. Но, в конечном счете, я также считаю, что нам нужно кое-что знать о том, как работает система. Потому что я думаю, что любой такой тест может быть пройден, если узкий искусственный интеллект будет достаточно мощным, достаточно изощренным и обученным на достаточном количестве данных.