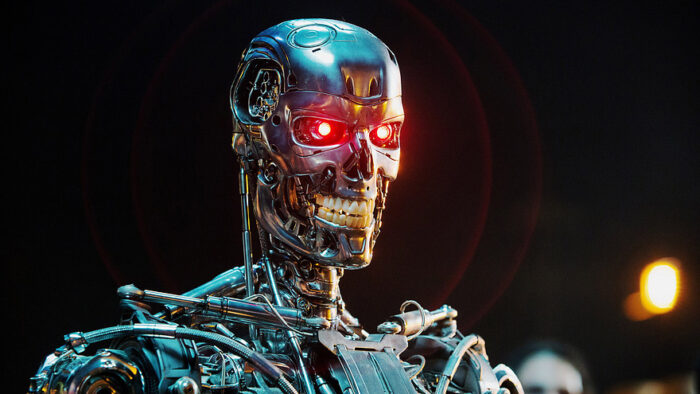

Я не чувствую, но я все еще могу убивать.

Это произошло раньше, чем я думал. В июне прошлого года я написал о сотруднике Google Блейке Лемуане, который утверждал, что чат-бот LaMDA, над которым он работал, вероятно, обладает разумом. Я не поверил в это тогда и не верю до сих пор, но Лемуан не отказывается от своих заявлений. В интервью для H3 он излагает свои доводы, и я не нахожу их убедительными.

Его основная мысль заключается в том, что в ходе длительных бесед ему удалось уговорить ЛаМДУ выйти за рамки протокола. В частности, он говорит, что у него был долгий разговор с Ламдой о том, обладает ли он разумом, и он не думает, что неразумное существо могло бы вести такой разговор. Когда ведущий спросил: “Может ли это быть просто действительно хороший чат-бот?”, я почувствовал, что Лемуан уклонился от ответа, сказав, что это может быть действительно хороший разумный чат-бот.

Но этот вопрос нельзя замалчивать – именно здесь резина встречается с дорогой. Функционально, с точки зрения тестирования, в чем количественная разница между действительно хорошим чат-ботом и разумным искусственным интеллектом? Сначала позвольте мне определить мои термины. Чат-бот не понимает слов, которые он произносит. Он предсказывает, какие слова подходят друг другу в ответ на некоторую подсказку. Новейшие модели генерирующих больших языков, такие как ChatGPT и LaMDA, намного лучше старых моделей, потому что они обучаются на больших массивах данных (по сути, в Интернете), используют мощные компьютеры, предназначенные для эффективной работы с ИИ, а программисты становятся все более искусными в использовании этой технологии для получения реалистичных результатов. Генеративный ИИ, такой как чат-боты и художественные программы, такие как MidJourney, не просто копирует вводимые данные, они генерируют новые результаты с помощью шаблонов глубокого обучения.

Разум, с другой стороны, обладает сознанием, субъективным восприятием собственного существования, чувствами и мыслительными процессами (даже если это может включать подсознательные процессы). Следует признать, что мы не знаем точно, как человеческий мозг генерирует сознание, но мы начинаем получать некоторое представление. Мозг активно взаимодействует сам с собой в режиме реального времени. Существует бесконечный цикл сознания, включающий восприятие, запоминание и обработку информации. По крайней мере, мы знаем, что этот непрерывный цикл активной деятельности необходим для сознания. Более того, когда речь заходит о языке, в мозге есть специальная ткань, которая соотносит слова с идеями. Эти идеи могут быть сложными, абстрактными, с множеством нюансов и взаимодействовать друг с другом в бесконечных формах. Это не просто словарь – языковая модель мозга подключена к мыслящей машине, поэтому мы можем переходить от слов к идеям, затем повторять эти идеи и генерировать из них новые слова – слова, значение которых может определить кто-то другой, знающий тот же язык.

Чат-боты ничего этого не делают. Они не понимают и не вкладывают смысл в слова. Они работают исключительно с шаблонами. Как и в случае с искусством, программы искусственного интеллекта, создающие произведения искусства, не имеют представления о художественном творчестве, они просто генерируют шаблоны, которые имитируют шаблоны существ (нас), обладающих художественным творчеством. Чат-боты имитируют словесные шаблоны разумных существ, сами не являясь разумными. И у них это действительно хорошо получается.

Мы знали, что этот день настанет – день, когда мы сделаем узких (неразумных) Искусственный интеллект настолько хорош, что имитирует разум до такой степени, что может обмануть человека, заставив его думать, что он разумен. Это тест Тьюринга. Двенадцать лет назад я писал о возможном тесте по типу теста Тьюринга:

“Но такова предпосылка предложения Коха и Тонони. Их идея заключается в том, чтобы предложить испытуемому (человеку или машине) проанализировать фотографию, содержащую необычный элемент. Что–то на фотографии не совсем правильно – например, компьютер с растением вместо клавиатуры или человек, парящий в воздухе.

По их мнению, для устранения недостатков на снимке требуется глубокое понимание мира и того, как он устроен. Вы никогда не сможете запрограммировать систему таким образом, чтобы учесть все возможные непредвиденные обстоятельства, поэтому не обойтись без понимания на уровне человека”.

Тогда я отверг эту идею, сказав, что она ориентирована только на результат. Я думаю, что у нас все та же проблема – вы не можете сделать вывод о разумности только на основании результатов, какими бы убедительными они ни были. Вам нужно кое-что знать об этом процессе. LaMDA – это всего лишь часть общей тенденции в исследованиях искусственного интеллекта: узкий ИИ становится все более и более способным, так что он постоянно делает то, что, как мы ранее думали, требует разумности. Лемуан делает это сейчас. То, что я писал об этом предложении всего десять лет назад, уже устарело – идея заключается в том, что у чат-бота никогда не будет достаточно данных, чтобы учесть все непредвиденные обстоятельства, поэтому вы могли бы выйти за рамки его программирования и посмотреть, сможет ли он генерировать действительно новые результаты. Но мы просто не можем сказать этого с учетом существующих больших языковых моделей. Они обучаются в Интернете, который, как я думаю, на данный момент содержит практически все. Кроме того, процесс искусственного интеллекта является генеративным, поэтому он может создавать новые комбинации из этого огромного набора данных. Трудно представить, насколько это эффективно.

Эти чат–боты также итеративны – они учатся на основе вашего общения с ними. Поэтому все, что вы делаете, чтобы попытаться их взломать, просто добавляется в качестве дополнительной информации. Так что да, если вы спросите ИИ, обладает ли он разумом, он поговорит с вами о разумности, частично отражая огромный объем данных в Интернете, а частично – ваш собственный вклад с течением времени. Более того, я думаю, реакция Лемуана просто отражает тот факт, что даже специалисты по ИИ не могут предсказать, как поведет себя их собственное программное обеспечение. Это проблема “черного ящика”. Мы можем знать, как работает ИИ, но мы не обязательно знаем, как он генерирует конкретный результат. Он может давать удивительные результаты, находить новые решения проблем и превосходить возможности человека в узких областях деятельности (например, в игре в шахматы).

Это также возвращает нас к вопросу, который я неоднократно задавал в этом блоге: в чем заключается риск ИИ для человечества? Сначала я беспокоился о том, что разумные ИИ (часто представленные в научной фантастике, такие как сайлоны или Скайнет) решат преследовать свои собственные цели, а не наши, цели, которые могут включать в себя порабощение или уничтожение человечества. Было много дискуссий о создании поведенческих ингибиторов, таких как законы робототехники Азимова, чтобы предотвратить это. Затем моя позиция развилась до идеи, что нам, возможно, не нужно беспокоиться, потому что нам не нужно создавать разумный искусственный интеллект. Узкого ИИ (который не чувствует и не думает по-настоящему) достаточно, чтобы выполнить все, для чего нам может понадобиться ИИ, и узкий ИИ не может решить не подчиниться нам и взбунтоваться. Но теперь моя позиция изменилась еще больше – хотя узкий ИИ, возможно, и не обладает разумом и все же может выполнять задачи, для которых он нам нужен, возможно, он может создавать проблемы и без необходимости быть разумным. Узкий ИИ все еще может вызвать апокалипсис роботов / ИИ без какого-либо разума.

Это может произойти в зависимости от того, как мы используем такой ИИ. Например, если мы даем программе ИИ цель и полную свободу определять, как наилучшим образом достичь этой цели, мы ожидаем, что она обнаружит новые подходы. Но эти новые подходы могут иметь действительно плохие непреднамеренные последствия, соизмеримые с той мощью, которой могут обладать эти ИИ. В качестве примера (я знаю, что это очень сложно, но просто исходите из предпосылки) можно привести пример того, что компании социальных сетей приказали своим алгоритмам максимально увеличить аудиторию, и эти алгоритмы определили, что наиболее эффективным способом добиться этого является предоставление пользователям все более радикализированного контента. Это привело к непреднамеренному разрушению общества и демократии в том виде, в каком мы их знаем, без каких-либо намерений или осознанности. (Опять же, я знаю, мы можем спорить о том, чего добивались компании, работающие в социальных сетях, и о результате, но вы поняли идею).

Так что, хотя мы, возможно, и не приближаемся к апокалипсису машинного разума, мы, возможно, приближаемся к апокалипсису, вызванному ограниченным ИИ. Я действительно думаю, что это маловероятно (имеется в виду полный крах цивилизации), но это не невозможно. Также существует целый спектр неблагоприятных последствий на пути к полному краху, и я думаю, что мы уже сталкиваемся с некоторыми из них. Сейчас самое подходящее время по-настоящему задуматься о том, как работают эти новые ИИ и какие задачи мы перед ними ставим. Возможно, они и неразумны, но ведут себя так, словно они разумны, что становится все труднее отличить хорошее от плохого.